Storm Isha is nog niet voorbij en de volgende storm in een glas water dient zich al weer aan. Ik ga proberen wat zaken aan elkaar te knopen en heel veel verwijzingen gebruiken om dit te doen. Maar eerst: spam was er al, google doet al jaren een kat en muis spel met spammers en de techniek helpt beide partijen vooruit. Zeker nu zich Ai heeft aangeklopt heeft dit veel impact, want spammers maken meer content, Google doet slimmere updates en komt met de ‘heilige graal’ oplossing in hun ogen. Search Generative Experience. Want als Google de Ai maakt bij de Query dan hoeven ‘content marketeers’ dit niet meer te doen. En we leefden nog lang en gelukkig.

Inhoudsopgave

Het is een column, rustig aan mensen.

Jan-Willem Bobbink

In de column haalt Laurens veel terechte punten aan en in mijn ogen een kleine misinterpretatie van het Duitse onderzoek.

Overigens staat het artikel achter een paywall, maar kun je de structured data wel lezen en dat is weer een heel ander probleem, waarvan Google zegt dat het eigenlijk niet bestaat als een journalist daar over begint:

Google Search and Google News are stuck in the past when it comes to these. It’s crawler assumes that paywalled or reg walled content is still going to be in the HTML that Google crawler will see. In other words, it demands leaky bad tech from sites with paywalled or registration required content. It’d be great if it fixed that instead of sending Danny Sullivan out to lecture sites about their markup with directions that don’t work for a smart, modern, non-leaky publishing system.

Ryan Singel, tech journalist (Ryan Singel – Wikipédia)

Danny, bij woorde van Google zegt dat dit ‘by design’ is, hoewel ik hier wat selectief hebt geknipt in het volledige antwoord (dat kun je hier lezen), geeft dit de strekking wel mooi aan:

There’s nothing “leaky” about this. That seems to be a suggestion that if someone lets us in, anyone can get in. That’s not the case. We can be specifically allowed in. If someone is concerned that makes cached content available, they can also block us showing cached content.

Danny Sullivan, @search_liasion

Hij heeft overigens verder nog wel tips hoe het wel moet verderop in de comments. Dus lees dat ook even, maar je hebt dus geen archive.ph nodig om iets van DPG te lezen 😉 maar dit allemaal terzijde. Terug naar het onderwerp.

Chantal heeft haar mening op SEObrein prima samengevat:

Ik heb het artikel nog eens gelezen en eigenlijk vat hij samen wat hij op de andere sites gezien, gelezen en gehoord heeft. Hij citeert de bronnen en verwijst ernaar. Eigenlijk bundelt hij het nieuws dat er momenteel rondom ons vakgebied is, daar kun je weinig fout aan doen. Dan haalt hij het voorbeeld van Jake aan wat ook niet meer dan terecht is. Dan kunnen we boos zijn op de journalist, het is Jake Ward waar we problemen mee zouden moeten hebben dat hij onze industrie zo neerzet. Juist door types als Jake, komt het dat de kranten zo over ons vakgebied gaan schrijven. Types als Jake zijn er echt heel veel en de hoeveelheid applaus onder hun cases geeft aan dat wereldwijd een hele grote groep het mega interessant vindt wat ze doen. Ik vraag me af welke nuance je (we) van hem had(den) gewild? Dat hij zegt: maar nuance is op z’n plaats want er zijn SEO’s die zich wel braaf aan de regels houden?

Ik snap dat als je als buitenstaander dit allemaal leest dat je inderdaad denkt: het internet is stuk. En het is ook in grote mate “stuk”… het is een kat-en-muis spel tussen SEO’s die het algoritme willen foppen, SEO’s die het algo slim inzetten en SEO’s die zich braaf aan de regels houden en zien dat ze voorbij gestreefd worden door sites met kutcontent. En het is Google die er achter aan loopt en probeert kaf van het koren te scheiden.

Ik heb echt verschrikkelijk slechte content gezien tijdens het analyseren van de websites die in Q4 geraakt zijn. Websites die een product aanraden zonder het ooit vast gehad of gebruikt te hebben. Alles zo lang de consument maar klikt en via hun affiliatelink koopt. Websites die tips geven over de producten die zij verkopen waarbij de input en teksten afkomstig is van andere sites, niet zelden in elkaar geflanst door content marketeers, copywriters of AI zonder echte kennis. Ik heb bij grote labels in de keuken gekeken, ik heb het zelf gezien.

Wat dat betreft zit de manier van werken echt op heel veel plekken erin geslopen en als het niet bij de SEO-specialist zelf zit, dan wel bij het C-level die snel wat geschreven wil hebben zonder daar budget voor vrij te maken.

Dus welke nuance willen we van hem? En als we die willen, dan moeten we misschien op een andere manier met hem in contact komen waarin we hem niet afbranden, beledigen maar met respect benaderen en zeggen: ik zou er graag wat over willen zeggen.

Chantal Smink – op SEOBrein

Prima samengevat en Jerrel doet ook een bijdrage in het zakje met truth bombs, die ik ook ietwat selectief heb geknipt en plakt:

Ik snap de verontwaardiging eigenlijk niet zo.

Als SEO community hebben we hele congressen gericht op hoe de media werkt en hoe we met trucjes kunnen zorgen dat er over onze klanten wordt geschreven.

Voor klanten lijken we best goed te begrijpen wat je moet doen om te zorgen dat de media jouw content gebruikt en ernaar linkt.

Nu gaat het een keer over onszelf. Waarom zijn we dan nu ineens verbaasd?

Ik denk dat niemand kan ontkennen dat er een groep rotte appels is die van het internet geen betere plek maken. Dat is een probleem. En dat heeft nieuwswaarde.

En dankje Jerrel, voor het voorzetje van het punt wat ik ook wilde maken:

Ik denk dat het gaaf zou zijn als de SEO community er ook zo in zou staan. Niet ontkennen, maar de goede kant laten zien en kritisch zijn op de groep die dit veroorzaakt.Ik heb vaak genoeg op een SEO borrel gestaan, waarbij iedereen vertelt over de linkjes die massaal worden gekocht op de websites die dit soort artikelen bedoelen. Nogmaals, niet iedereen doet hier aan mee. Maar laten we ook niet net doen of dit alleen in India gebeurt.

Het klantenbestand van allthewayup, popinl, backlinksnl en hulc is goed gevuld met Nederlandse opdrachtgevers. Van groot tot klein.

Overigens heb ik daar geen problemen mee, het kan prima conform de wet, klanten zijn tevreden voor wat ze krijgen. Google heeft alleen maar richtlijnen waar je je tot toe kunt wenden als het allemaal toch niet zo lukt als dat je graag zou willen.

Maar waar zijn de branche-organisaties?

Één ding wat ik hier in mis. Niet dat ik verbaasd ben, want ik heb ook in een taskforce voor het iAB gezeten heel lang geleden. Daarin wilden we de markt (let wel: adverteerders is de markt voor het iAB) helpen met een paper waarin we ons zouden commiteren aan de richtlijnen als brancheorganisatie, maar uiteindelijk is dat toch maar gescrapt, want daar wilden de bureaus allemaal niet aan meewerken.

Leuk dat we ons hier als freelancers en eenpitters of ‘arbeiders’ druk over maken, anderzijds zou je kunnen zeggen dat de branche en agencies zich focussen op de grote lijn…

Maar de branche verenigingen laten agencies die overduidelijk de richtlijnen niet volgen (links of linkplaatsingen, of geschreven artikelen met links kopen) gewoon lid zijn van de club en en zwijgen verder als het graf over dit soort zaken.

De grens tussen content en spam

Erwin Boogert heeft, in mijn ogen, op Emerce wel een goed en gebalanceerd stuk geschreven en daadwerkelijk het Duitse onderzoek gelezen en goed begrepen waar een deel van de ophef over is (PDF, code en data).

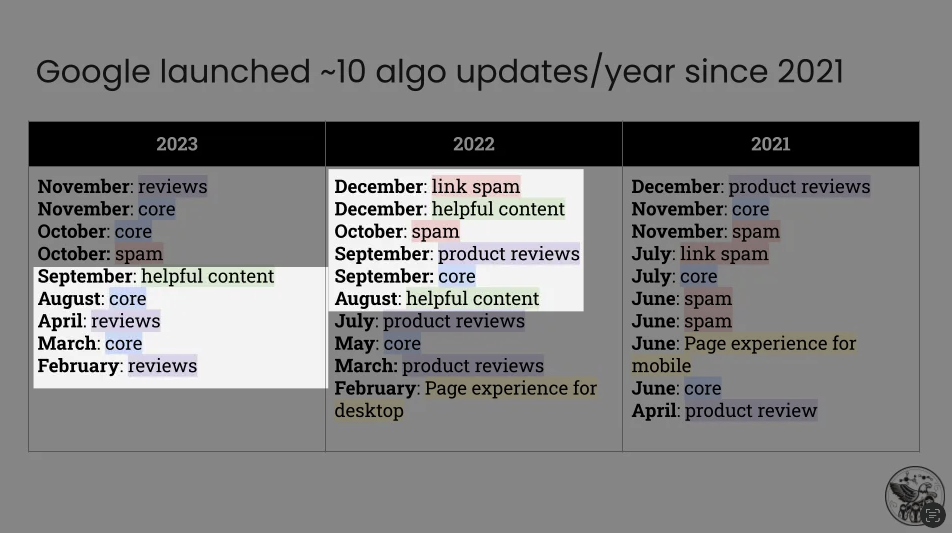

In zijn artikel ‘de grens tussen spam en content vervaagd’ brengt hij wat mij betreft de juiste nuance aan. Daarnaast staat op pagina 4 dat het onderzoek een periode beslaat vanaf augustus 2022 tot september 2023, waarin elf substantiële updates aan Google’s algoritmes plaatsvonden, waaronder drie updates voor nuttige content en drie updates voor productrecensies.

De Duitse studie heeft ook een verband gevonden tussen zoekoptimalisatie en een lagere waargenomen kwaliteit staat dan ook op pagina 3 van de PDF.

De najaarsstorm van Google is dus niet meegenomen. En daar hebben veel sites toch behoorlijk last van gehad.

Dat onderzoek geeft vooral de conclusie dat de content op het internet slechter wordt, dat Google het amper bij kan houden maar wel het beste doet van alle zoekmachines.

However, we also notice that the line between benign content and spam in the form of content and link farms becomes increasingly blurry—a situation that will surely worsen in the wake of generative AI. We conclude that dynamic adversarial spam in the form of low-quality, mass-produced commercial content deserves more attention.1

Google vind het zelf publieke gezien nog wel meevallen, geven ze als reactie te lezen op ars technica.

“This particular study looked narrowly at product review content, and it doesn’t reflect the overall quality and helpfulness of Search for the billions of queries we see every day. We’ve launched specific improvements to address these issues – and the study itself points out that Google has improved over the past year and is performing better than other search engines. More broadly, numerous third parties have measured search engine results for other types of queries and found Google to be of significantly higher quality than the rest.” – Google Spokesperson

Zoeken in TikTok de weg voorwaarts?

Uit ander recent onderzoek van Adobe blijkt dat ons zoekgedrag verandert. Je verwacht het niet. Nou is dit onderzoek vooral onder Amerikanen gedaan, maar toch. Het is voor Google wel een grote alarmbel.

- Meer dan 2 op de 5 Amerikanen gebruiken TikTok als zoekmachine.

- Bijna 1 op de 10 Gen Z’ers vertrouwen meer op TikTok dan op Google als zoekmachine.

- Meer dan de helft van de bedrijfseigenaren (54%) gebruikt TikTok om hun bedrijf te promoten, gemiddeld 9 keer per maand.

- 1 op de 4 kleine bedrijfseigenaren gebruikt TikTok influencers voor productverkoop of promoties.

Dat heeft natuurlijk ook deels te maken met dat mensen niet zo gelukkig worden van de zoekresultaten, of dat ze gewoon wat visueler willen denken en zoeken.

Agents of change

Als we dit allemaal bij elkaar optellen dan wordt het komende jaar voor uitgevers/publishers behoorlijk klote. 2023 was al geen feest voor sommige publishers. Als je het idee had dat je E-E-A-T nog kon fixen door een auteursbiografie op de pagina te zetten dan is dat vanaf nu je minste probleem.

Cookies gaan echt drastisch veranderen, en Google is nu wel klaar om consent-mode verplicht uit te rollen begin maart.

De systemen (en Google Chrome) zijn nu zoveel aangepast dat Cookies voor Google niet meer nodig zijn om hun centen te blijven verdienen. Dus eind van het jaar gaat er ook een streep door third-party cookies. Hier ga je dit jaar ook bij mij nog wel meer over lezen, maar het zegt iets over een ongunstig klimaat.

Google’s oplossing: Search Generative Experience

Maar Google heeft nog een wapen in het arsenaal. Google is altijd goed geweest is ‘cut out the middlemen’ en dat gaan ze nu weer proberen. Nu met ai. Letterlijk. Want als Google alvast de samenvatting voor je maakt, dan hoef je het als blogger of reviewwebsite niet te doen.

Tada! Search Generative Experience in een notendop. Dit gaat bedrijven (adverteerders), review-sites (affiliates en dus bedrijven) en SEO’s (advies voor bedrijven, affiliates en adverteerders) wel gewoon echt pijn doen. Je businesscase gaat geen mooi verhaal meer zijn. Zie bijvoorbeeld de situatieschets van Wall Street Journal:

About 40% of the magazine’s web traffic comes from Google searches, which turn up links that users click on. A task force at the Atlantic modeled what could happen if Google integrated AI into search. It found that 75% of the time, the AI-powered search would likely provide a full answer to a user’s query and the Atlantic’s site would miss out on traffic it otherwise would have gotten.

While Google says the final shape of its AI product is far from set, publishers have seen enough to estimate that they will lose between 20% and 40% of their Google-generated traffic if anything resembling recent iterations rolls out widely.

Bron: Wall Street Journal

Er zijn al best wat voorbeelden uit de US waarin in de impact van SGE word beschreven, zoals dit onderzoek van Brightedge, dit onderzoek van Agile SEO, of dit onderzoek van authoritas.com, genoeg voorbeelden die niet heel rooskleurig uitpakken, maar ook de impact op PPC blijft niet onbesproken gelukkig!

Our 2015 (admittedly very outdated) click-thru study showed a drop in click-thru rates from 21.4% to 2.7% for non-branded terms on desktop devices.

Authoristas.com

Daarom zet Google zo erg in op SGE. Het zorgt ervoor dat de middle men minder nodig is.

De EU ligt misschien nog wel wat dwars, maar we weten allemaal dat het gaat komen. In welke vorm is nog niet helemaal duidelijk, ook binnen Google zelf niet, want de veranderingen in de US zijn ook nog steeds enorm. En eerlijk gezegd wil ik mij nog niet druk maken hierover, want ik kan wel schakelen als het zover is en ik focus mijzelf met mijn werk al jarenlang op de gebruikers en niet op Google.

Ai bij Google zelf

Google heeft ondertussen ook nog flink wat mensen ontslagen waaronder een flinke hoeveelheid Quality Raters via Appen. Dus het lijkt erop dat Google de input voor goed en slecht redelijk onder controle denkt te hebben en minder mensen nodig heeft dan in het verleden.

Wat ook uit het eerder genoemde Duitse onderzoek blijkt is dat het is niet heel moeilijk om affiliates te herkennen voor de onderzoekers, dan zou het voor Google toch helemaal een eitje moeten zijn? Dit is natuurlijk speculatie, want ook Google is heftig in de kosten aan snijden op andere afdelingen (veelal advertising en sales), en intern voelen en uiten mensen dat ook.

Ik kan mij voorstellen dat algoritmes nu niet meer vragen om ‘input’, maar bijvoorbeeld om ‘controle’. Waarbij het algoritme al zaken heeft bepaald en ter ‘goedkeuring’ aan de Quality Rater vraagt of de AI bevindingen correct zijn. Allemaal speculatie uiteraard.

Maar SGE betekent dus ook dat ‘publishers’ nog meer onder druk komen staan dan ze al doen. De businessmodellen zijn lastiger, je content wordt als bron gebruikt om je de nek om te draaien, aldus een aanklacht van de NYT tegen openai. Hoewel Openai daar iets anders tegen aankijkt en Google ook een iets andere visie heeft, verwacht ik dat de EU toch deels de kant van de uitgevers en publishers zal kiezen.

Misschien overweegt Google ook wel, zo gauw ze dat daadwerkelijk kunnen erkennen, om hun visie op AI in zoekmachines te herzien. Iets wat Kevin Indig ook allemaal prachtig op een rij heeft gezet in ‘free content’, wat dan overigens ook weer koren op de molen is van zijn sponsor die hierin ook wat advies geeft waar ik het dan nog niet mee eens ben…

Tot slot…

Als SEO is het verstandig om je te focussen op intenties die niet makkelijk te ai-en zijn, triggers voor SGE zijn onder andere ‘How, Best, Near en Cost’, het is sterk intentie gedreven.

Ik verwacht dat bijvoorbeeld lister pagina’s met faceted search etc maar weinig traffic zullen overhouden, want ‘Google kan het immers beter’ :’) .

De grote troost is dat je makkelijk in de SGE kunt komen terwijl je niet een toppositie hebt.

…demonstrate that these methods are capable of boosting source visibility by up to 40% in generative engine responses. Among other things, we find that including citations, quotations from relevant sources, and statistics can significantly boost source visibility.

Bron: https://arxiv.org/abs/2311.09735

Om af te ronden: 2024 is hét jaar voor SEO’s om wakker te worden. Ik herhaal het nog een keer: ik wil nooit meer ‘seo-content’ horen. Elke keer dat je dat zegt worden en 10 content-goblins geboren die op jouw posities gaan azen! Hoog tijd om je SEO playbook te gaan updaten en SEO te gaan doen voor je 1st party data.

Dan hoef je je ook niet zo druk te maken over attributie, want uiteindelijk is dat niet waar het om gaat, maar wil je juist gaat kijken naar een incrementaliteit, en laat ik daar pas nog een blogartikel over hebben geschreven en ik verwacht dat je daar dit jaar nog wel vaker over gaat lezen. SEO blijft veranderen. We moeten flexibel zijn. Dus, laten we ons spel verbeteren en groeien in dit boeiende vakgebied.

Mocht je nou graag ook nog het internet willen verkloten door LLM’s te beïnvloeden, dan kun je bij Malte vast wat inspiratie opdoen!

Dit artikel is helemaal zonder Ai geschreven. Maar het plaatje niet. Ik vind het supertof als een je opmerking achter wilt laten of het wilt of kunt aanvullen. Ook als je vind dat ik van de hak op de tak ga en dit niet goed genoeg uitleg hoor ik graag je feedback.

Geef een reactie